世界のデータセンターGPU市場規模/シェア/動向分析レポート(2025年~2030年):ジェネレーティブAI、機械学習、自然言語処理、コンピュータビジョン

市場概要

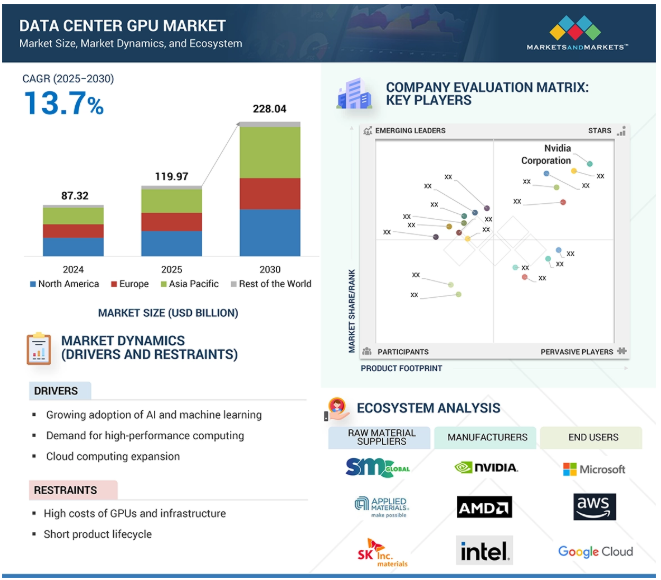

世界のデータセンター向けGPU市場は、2025年の1,197億7,000万米ドルから2030年には2,280億4,000万米ドルに成長すると予測され、予測期間中の年平均成長率は13.7%です。

データセンターにおけるGPUの需要は、主に人工知能(AI)と機械学習(ML)が急速に進歩し、さまざまな業界で広く採用されていることから、大きな伸びを示しています。AIモデルの複雑化と学習に必要な大規模データセットの増加により、GPUが提供する高性能な並列処理機能が必要とされています。AIアプリケーションの性能ベンチマークは、データセンター内の堅牢なGPUインフラストラクチャへの大規模な投資を促します。リアルタイム推論と、GPUによって実現されるデータ分析の高速化に対するニーズの高まりは、競争上の優位性を求める企業にとって極めて重要になっています。同時に、大規模なデータセンター運用に伴う大幅な電力消費を削減し、持続可能なイニシアチブをサポートするために、エネルギー効率の高いGPUソリューションが重視されるようになっています。

DRIVER: AIと機械学習の採用拡大

機械学習(ML)と人工知能(AI)の利用が増加しており、高性能データセンターGPUの需要が高まっています。不正検出、自律走行車、推薦システム、自然言語処理などのアプリケーションは、強力な並列処理能力を必要とするため、データセンターには高速コンピューティングが不可欠です。A100やH100などのNVIDIAのTensor Core GPUは、AIのトレーニングや推論に広く使用されています。2024年、マイクロソフトとエヌビディアは、Azure向けのAIスーパーコンピューティング・インフラの構築に向けて協業を拡大。ハイパースケール環境での採用が増加しているMI300 GPUに見られるように、AMDもパートナーシップで地歩を固めています。グーグル、メタ、アマゾンはカスタムAIチップに投資していますが、特定のワークロードについてはサードパーティのGPUに依存しています。AIの状況が進化するにつれ、データセンターGPU市場は、計算集約的なAIモデルの需要とともに成長することになるでしょう。

制約事項 製品ライフサイクルの短さ

データセンター向けGPU市場における主な課題の1つは、GPUハードウェアの寿命が短いことです。AI、ML、ハイパフォーマンス・コンピューティングの急速な進歩と性能要求の高まりにより、GPUベンダーは新バージョンを頻繁にリリースする必要があります。このような状況は、多額の初期投資とインフラストラクチャーのアップグレードの絶え間ない必要性に直面するデータセンター事業者にプレッシャーを与えます。例えば、NVIDIAは2020年半ばにA100 GPUを発表し、そのわずか2年後にはHopperアーキテクチャに基づくH100 GPUを発表しました。こうした絶え間ないアップグレードは、旧モデルの減価償却を早めることにつながり、特に定期的なアップグレードを容易に吸収できない中小企業にとっては、長期的なROIの妨げになります。さらに、GPUの世代が新しくなるたびに、ソフトウェア・スタックとワークロードの調整が必要になり、複雑さと運用上のオーバーヘッドが増えます。その結果、このような短い製品ライフサイクルは、安定性と長期的価値を重視する市場での採用を妨げる可能性があります。

可能性:自律システムの成長

自動運転車、ドローン、ロボットなどの自律型テクノロジーの出現は、データセンターGPU業界に大きなチャンスをもたらしています。これらのテクノロジーは、コンピュータ・ビジョンやリアルタイムの意思決定といった高度なAIアルゴリズムに依存しており、いずれも膨大な計算能力を必要とします。例えば、TeslaのDojoスーパーコンピュータは、自律走行ソフトウェアをトレーニングしており、GPUアクセラレーション・インフラストラクチャの必要性を示しています。NVIDIAは、メルセデス・ベンツやボルボなどの自動車会社と提携し、自律走行開発のためのNVIDIA DRIVEなどのプラットフォームを提供しています。2023年には、NVIDIAとFoxconnが協力して、自律型プラットフォームに特化したAI工場を設立しました。

またAmazonは、GPUがサポートするAWSインスタンスを自律型ドローンのナビゲーションに使用しています。企業が自律性をますます採用するようになるにつれて、スケーラブルなGPU駆動型データセンターの需要が高まり、GPU市場はモビリティとロジスティクスにおけるこの革命に資本投下することができます。

課題:代替技術の存在

データセンター向けGPUの成長は、特定用途向け集積回路(ASIC)やフィールド・プログラマブル・ゲート・アレイ(FPGA)などの代替技術による課題に直面しています。これらの代替技術は、特殊なワークロードに対して、ワットあたりでより優れた性能を提供することがよくあります。例えば、GoogleのTensor Processing Units(TPU)は、機械学習とAIに最適化されたASICで、TensorFlowモデルの学習と推論を汎用GPUよりも高速に実行できます。同様に、Amazon Web Services(AWS)は、EC2 F1インスタンスでFPGAを提供しており、ゲノム解析やビデオエンコーディングなどのタスクのためのカスタムハードウェアアクセラレーションを可能にしています。Microsoft AzureはProject Brainwaveを通じてFPGAを統合し、リアルタイムのAIパフォーマンスを向上させています。特にハイパースケール環境では、このような電力効率の高いテクノロジが普及するにつれて、GPUベンダーは競争力を維持し、コストと電力要件を正当化するために適応する必要があります。

さらに、これらの外骨格は通常、1回の充電で数時間しか動作しないため、充電やバッテリー交換のために頻繁にダウンタイムが発生します。軍事任務や時間に敏感な産業環境など、連続動作が重要な環境では、これは深刻なリスクをもたらす可能性があります。例えば、軍事用途では、突然の停電により兵士の移動が妨げられたり、脆弱な立場に置かれたりする可能性があります。産業環境では、ユーザが作業を一時停止するか、装置を切り替える必要があるため、電力制限によってワークフローが中断され、生産性が低下する可能性があります。充電インフラが限られていたり、実用的でない遠隔地や需要の高い場所では、この問題はさらに深刻になります。このような制約は、技術的な強化と運用の信頼性との間の大きなトレードオフを浮き彫りにします。

主要企業・市場シェア

データセンターのGPUエコシステムは、データセンター環境における計算集約的なワークロードを高速化するために設計されたハイエンドのグラフィックス・プロセッシング・ユニットをベースとするダイナミックで急速に進化するランドスケープです。このエコシステムには、原材料サプライヤー、ファウンドリ、データセンター向けGPUメーカー、サーバーOEMおよびODM、エンドユーザーなどの利害関係者が含まれます。エンドユーザーは、Microsoft(アメリカ)、Google(アメリカ)、AWS(アメリカ)などのクラウドサービスプロバイダーが中心です。データセンター向けGPU市場に参入している主な企業は、Nvidia Corporation(アメリカ)、Advanced Micro Devices, Inc. (アメリカ)などがあります。

展開別では、クラウド分野が予測期間中、市場の主導的地位を維持する見込み

柔軟で手頃な価格のAIと高性能コンピューティングに対する需要の高まりにより、クラウド導入はデータセンターGPU市場で大きな成長が見込まれます。クラウドプロバイダーは、AI、機械学習、分析、複雑なシミュレーションをサポートするために、強力なGPUをインフラストラクチャに統合しています。このクラウドベースのGPUアクセスにより、企業は物理インフラに関連するコストを削減し、ハイパワー・コンピューティング・リソースをより利用しやすくなります。Amazon Web Services(AWS)、Microsoft Azure、Google Cloudなどの大手企業は、競ってGPUの提供を強化しています。AWSはAIトレーニング用にNVIDIAを搭載したEC2インスタンスを提供し、Azureはエンタープライズ・ワークロード用の高度なGPU向けにNVIDIAと提携し、Google Cloudはスケーラブルなタスク向けにNVIDIA L4 GPUをサポートし、Oracle Cloud InfrastructureもオンデマンドAIソリューション向けにNVIDIAと提携しています。

機能別では、推論セグメントが2025年から2030年にかけて高いCAGRを記録する見込み。

データセンターGPUの推論セグメントは、チャットボットやレコメンデーションエンジンのようなリアルタイムアプリケーションでのAIの利用が増加しているため、大きく成長する見込みです。AIモデルは学習後、高負荷下で低レイテンシの推論を行うために大きなGPU容量を必要とするため、推論に最適化されたGPUの需要が高まっています。NVIDIAの最新のL4およびH100 GPU、Metaの広範なGPU利用、Microsoft AzureのAIサービス統合は、この傾向を浮き彫りにしています。ChatGPTやDALL-EのようなジェネレーティブAIアプリケーションは、推論ワークロードをさらに増加させ、データセンターにおける効率的でスケーラブルなコンピューティングの必要性を高めています。

ジェネレーティブAIは2025年から2030年にかけて大きな市場シェアを獲得

ジェネレーティブAIは、LLM、動画・画像作成、コード作成、音声アシスタントなどのアプリケーションに牽引され、データセンターGPU市場で大きく成長する見込みです。高性能GPUは、OpenAIのGPT-4、Google Gemini、MetaのLLaMAなど、これらの計算集約的なモデルに需要があります。企業はこの需要に応えるために多額の投資を行っています。MicrosoftはOpenAIと提携し、NVIDIA GPUに依存するChatGPTをAzureに統合しました。Google Cloudは、BardやDuet AIなどのサービスにTensor Processing Units(TPU)とNVIDIA GPUを使用しています。Metaは、何千ものNVIDIA GPUを搭載したAIスーパーコンピュータ「Research SuperCluster」を構築しています。Amazon Web Services(AWS)もまた、生成モデル開発用にNVIDIA GPUを搭載したEC2 UltraClustersを拡張しています。ジェネレーティブAIがヘルスケア、金融、マーケティング、デザインに拡大するにつれ、高品質なGPUベースのインフラへのニーズがこの分野の成長を促進するでしょう。

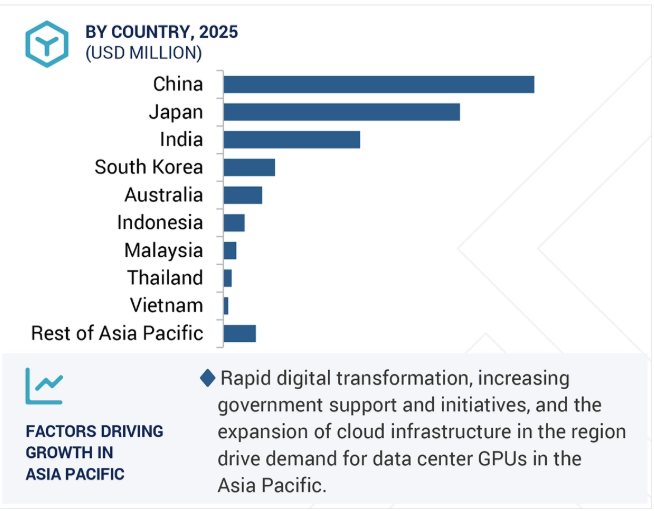

アジア太平洋地域は、中国、インド、日本、韓国、東南アジアなどの国々における急速なデジタル化、AI導入の増加、クラウドインフラの拡大により、データセンターGPU市場で大きな成長が見込まれています。中国は、AIとクラウドコンピューティングを推進する「新インフラ」政策でリードしています。Alibaba Cloud、Tencent Cloud、Baiduなどの大手企業は、AIモデルのトレーニングに高性能GPUを活用しており、BaiduのPaddlePaddleはNVIDIAのGPUを利用しています。インドでは、Google CloudとMicrosoft Azureが新興企業向けにGPUをサポートしたデータセンターを構築しており、韓国のNaverとKakao、日本の富士通とNECがAIイニシアチブを推進しています。NVIDIAやAMDとのコラボレーションにより、GPUベースのクラウドサービスがさらに強化されています。全体として、同地域のデータセンターGPU市場は、政府の取り組みとAIアプリケーションの需要増加により、大幅な成長が見込まれています。

アリババクラウドは2025年1月29日、AIモデル「Qwen 2.5」のアップデート版「Qwen 2.5-Max」をリリースしました。Alibaba Cloudによると、Qwen 2.5-Maxは11のベンチマークでDeepSeek-V3やMetaのLlama 3.1などのモデルを上回っています。今回のリリースは、急速に進化するAIの状況において、AI能力を向上させ、競争力を維持するための同社の継続的な取り組みを反映したものです。

2024年12月、AWSはAmazon Bedrockに統合された新しい基盤モデルファミリーであるAmazon Novaを発表しました。これらのモデルは、ジェネレーティブAIの機能を強化し、企業がテキスト、画像、動画をより効率的に作成できるように設計されています。

2024年10月に発表されたAMD Instinct MI325Xは、データセンターにおけるAIおよび機械学習ワークロード向けに設計されています。高い演算性能を提供し、複雑なレンダリングおよびシミュレーション・タスク向けに最適化されています。このGPUは、AI主導のビジュアライゼーション、メディア・レンダリング、データ集約型アプリケーションに適しています。

AMDは2024年8月、データセンター・ハードウェア企業のZT Systemsを現金と株式で買収することで合意しました。ZTシステムズのクラウド・コンピューティング・ソリューションの設計と最適化に関する専門知識は、AMDのデータセンターAIインフラ提供の強化につながると期待されています。

2024年4月、エヌビディアはイスラエルを拠点とするAIインフラプラットフォーム、Run:aiの買収を完了。この買収は、データセンターにおけるAIワークロードの管理と最適化のための高度なツールを提供することで、NVIDIAのAIインフラストラクチャーの提供を強化することを目的としています。

2024年7月、AMDはAIソフトウェア企業のSilo AIを買収。この買収は、特にデータセンター向けの高度なAIソリューションの開発において、AMDのAI能力を強化することを目的としています。

データセンター向けGPU市場を支配するプレイヤーは以下の通り:

NVIDIA Corporation (US)

Advanced Micro Devices, Inc. (US)

Intel Corporation (US)

Google (US)

Microsoft (US)

Amazon Web Services, Inc. (US)

IBM (US)

Alibaba Cloud (China)

Oracle (US)

CoreWeave. (US)

Tencent Cloud. (China)

Vast.ai (US)

Lambda (US)

DigitalOcean (US)

JarvisLabs.ai (India)

【目次】

はじめに

27

研究方法論

33

要旨

45

プレミアムインサイト

49

市場概要

53

5.1 はじめに

5.2 市場ダイナミクス ・AIと機械学習の採用拡大 ・ハイパフォーマンスコンピューティング(HPC)の需要拡大 ・クラウドコンピューティングの拡大 阻害要因 ・GPUとインフラのコスト高 ・製品ライフサイクルの短さ チャレンジ ・自律システムの成長 ・エッジコンピューティングの出現 ・量子コンピューティングの進歩 シナジー チャレンジ ・代替技術の存在 ・厳しい規制の枠組み ・サプライチェーンの混乱

5.3 ポーターの5つの力分析

5.4 エコシステム分析

5.5 バリューチェーン分析

5.6 規制のランドスケープ 規制機関、政府機関、その他の機関 標準規格規制- 北米- ヨーロッパ- アジア太平洋- ロウ地域

5.7 貿易分析 輸入データ(HSコード847330) 輸出シナリオ(HSコード847330)

5.8 価格分析 主要企業が提供するデータセンター用GPUの機能別価格動向(2024年) データセンター用GPUの主要企業別価格動向(2024年) データセンター用GPUの地域別平均販売価格(2021~2024年) (米ドル

5.9 技術分析 主要技術 – 並列処理アーキテクチャ – 高帯域幅メモリ(HBM) 副次的技術 – 特定用途向け集積回路(ASIC) – フィールドプログラマブルゲートアレイ(FPGA) 副次的技術 – 不揮発性メモリエクスプレス(NVMe) – インフィニバンド

5.10 特許分析

5.11 ケーススタディ分析メディアとエンターテインメントの分散型デジタル世界 テレイ・セラピューティクス – 低分子創薬にジェネレーティブAIを活用 シーメンス・ヘルスイニアーズ – AIによるがん放射線治療の合理化 GAC R&Dセンター – NVIDIA製GPUで車両の空力特性を向上 ストーンリッジ・テクノロジー – エシュロン2.0でコンポジションモデルのランタイムを短縮

5.12 主要な利害関係者と購入基準 購入プロセスにおける主要な利害関係者 購入基準

5.13 2025~2026年の主要会議とイベント

5.14 投資と資金調達のシナリオ(2023年第1四半期~2024年第2四半期

5.15 顧客ビジネスに影響を与えるトレンド/混乱

5.16 トランプの影響概要

5.17 主要関税率

5.18 各地域への主な影響 アメリカ ヨーロッパ アジア太平洋地域

5.19 アジア太平洋地域のサプライチェーンへの影響

5.20 USMCA協定に基づくトランプ関税におけるGPUの免除と抜け穴

5.21 エンドユーザー別産業レベルの影響

gpu-as-a-service(gpuaas)の展望

99

6.1 導入

6.2 サービスモデル IAAS- エッジコンピューティングとリアルタイムデータ処理の台頭がセグメントの成長を後押し PAAS- コスト効率、拡張性、運用の簡素化がセグメントの成長に貢献

6.3 デプロイメント パブリッククラウド – スケーラビリティとハイパフォーマンス・コンピューティング機能によりセグメント成長を促進 プライベートクラウド – 制御、セキュリティ、カスタマイズの強化によりセグメント成長を促進 ハイブリッドクラウド – ダイナミックなワークロードを処理する能力とデータセキュリティによりセグメント成長を加速

データセンター向けGPU市場:導入形態別

119

7.1 導入

7.2 柔軟性、拡張性、コスト効率の向上が成長を促進するクラウド

7.3 制御と性能に対する需要の高まりがオンプレミスGpuの導入を促進

データセンター用GPU市場、機能別

124

8.1 導入

8.2 トレーニング用GPUによる並列処理が、データセンターにおける機械学習モデル開発を加速

8.3 推論のリアルタイム意思決定が、データセンターにおける低遅延Gpu推論の需要を促進

データセンター用GPU市場、用途別

129

9.1 導入

9.2 Generative AI Generative AIがデータセンターにおける前例のないgpu需要を掘り起こす ルールベースのモデル 統計モデル ディープラーニング Generative Adversarial Network (Gans) オートエンコーダ Convolutional Neural Network (Cnns) トランスフォーマーモデル

9.3 機械学習 機械学習のフットプリント拡大がデータセンターのGpu成長を牽引

9.4 自然言語処理Gpuの高速化がNLPのデータセンター支配を促進

9.5 コンピュータ・ビジョン gpuを搭載したコンピュータ・ビジョンがデータセンターの成長を牽引 データセンターGPU市場、エンドユーザー別

データセンターGPU市場:エンドユーザー別

143

10.1 はじめに

10.2 クラウドサービスプロバイダーによるAIおよび機械学習アプリケーション向けデータセンターGPUの利用が市場を牽引

10.3 ENTERPRISES ENTERPRISE AI ADOPTION FUUSS ROBUST GROWTH IN DATA CENTER GPU DEMAND HEALTHCARE- 医療分野での機械学習(ML)および深層学習(DL)モデルの利用拡大が市場を促進 BFSI- BFSI企業によるHPC利用の拡大が市場を牽引 AUTOMOTIVE- 自律走行車の普及が市場を牽引。自律走行車の普及がGPUの採用を促進 RETAIL & E-COMMERCE- 膨大な量の小売・電子商取引データを処理する必要性の高まりがGPUの採用を加速 MEDIA & ENTERTAINMENT- コンテンツの作成と推薦にAIを利用する動きが市場を牽引 OTHERS

10.4 政府機関 国家安全保障のための政府機関による AI 採用の増加が市場を牽引

…

【本レポートのお問い合わせ先】

www.marketreport.jp/contact

レポートコード:SE 8838

- 世界の鉄粉市場(2025年~2033年):種類別(減圧式、噴霧式)、用途別(自動車・輸送機器、工業・機械、電子・電気)、地域別

- 世界の不動産市場規模、シェア、成長分析-予測動向・展望(2025-2034)

- イソアミルアルコール市場2025年(世界主要地域と日本市場規模を掲載):イソアミルアルコール(98%)、イソアミルアルコール(99%)

- 三次元測定機(CMM)の中国市場:ブリッジ三次元測定機、水平三次元測定機、咬合アーム三次元測定機、その他

- バイオシミラーの世界市場(2025-2033):市場規模、シェア、動向分析

- 世界のバナナ粉市場規模/シェア/動向分析レポート(2025年~2032年):食品、飲料、ペットフード、その他

- 半導体排ガス処理システム市場2025年(世界主要地域と日本市場規模を掲載):燃焼洗浄式、乾式、触媒式、湿式、プラズマ湿式、その他

- 世界のSTATCOM市場(2025年~2033年):定格電力別、最終用途別(ユーティリティ、鉄鋼製造、鉱業、再生可能エネルギー、水素発電所)、地域別

- 3-アミノ-2,6-ジフルオロ安息香酸(CAS 83141-11-1)の世界市場2019年~2024年、予測(~2029年)

- 酸化亜鉛ヒュームの世界市場

- 繊維強化レディーミクストコンクリートの世界市場2025:種類別(トランジット混合コンクリート、シュリンク混合コンクリート、中央混合コンクリート)、用途別分析

- 世界の吸入療法用ネブライザー市場(2025 – 2033):種類別、 用途別、エンドユーザー別、地域別分析レポート